Yo mismo logré crear una de las pocas herramientas existentes capaces de comprender lo que los usuarios esperan de las páginas web, los temas que faltan en sus artículos e identificar las páginas que están suponiendo un desperdicio masivo del crawl budget que ofrece Google. Vaya por delante que la intención de este artículo no es la autopromoción; simplemente quiero compartir mis reflexiones, necesidades y frustraciones en el uso de herramientas inadecuadas que me llevaron a crear una propia que consiguiera hacer lo que necesitaba. Una herramienta que no solo muestra datos sino que los procesa con algoritmos avanzados para transformarlos en información valiosa que nos permite actuar de manera concreta y obtener resultados inmediatos.

Cómo descubrir el potencial SEO de tu web

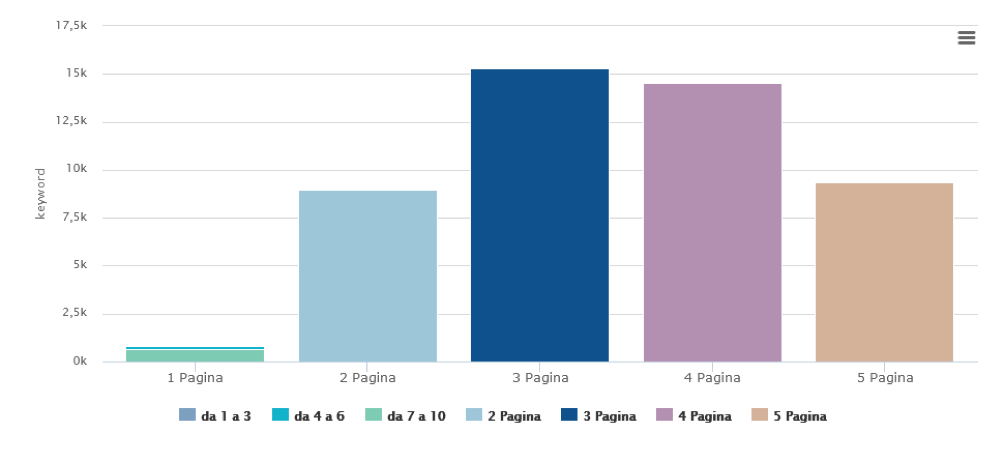

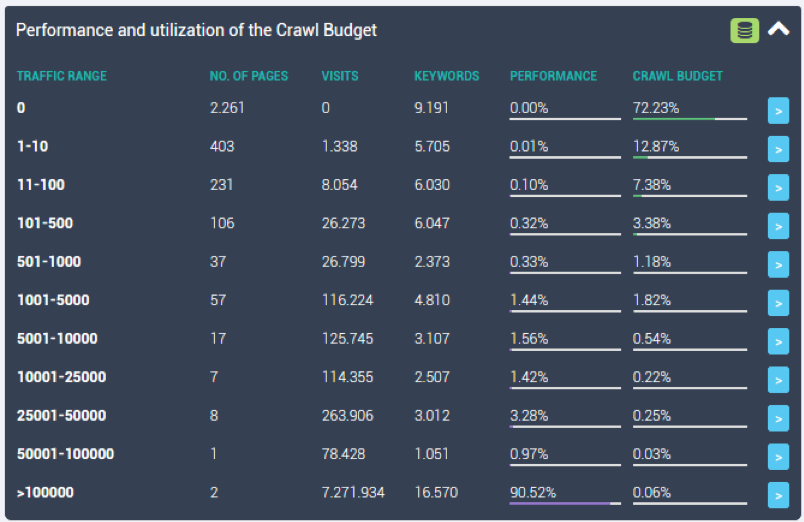

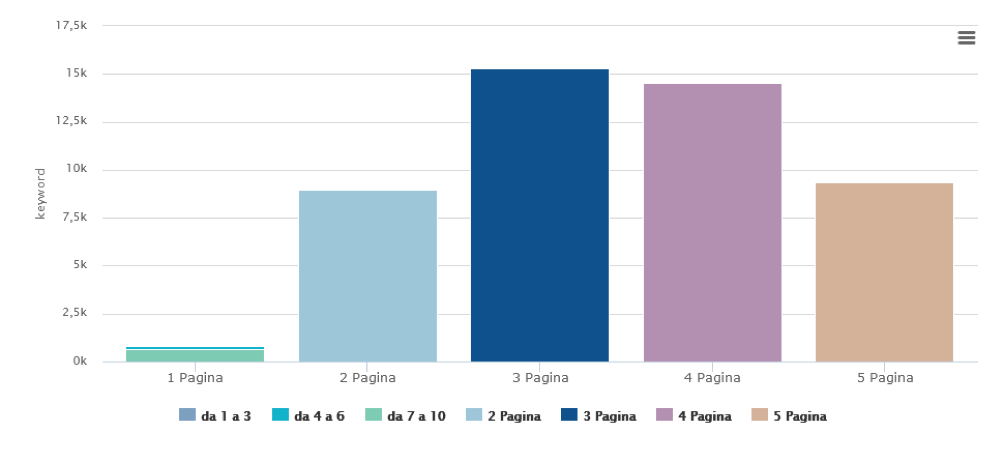

Cada web, incluso aquella que podríamos considerar “mala” porque no recibe tráfico de motores de búsqueda, tiene un potencial sin explotar. Hay muchísimas oportunidades de aumentar el tráfico que desaprovechamos debido a problemas técnicos de SEO o contenido que no está totalmente enfocado en las necesidades de los usuarios, tal y como se muestra en el gráfico a continuación:

En este gráfico vemos un sitio web con decenas de miles de keywords potenciales, pero pocas de ellas se encuentran entre las diez primeras.

En doce años de trabajo como consultor de SEO, cuando trabajo con un nuevo cliente, siempre le he dado un papel importante al estudio del potencial SEO de una web en mi análisis preliminar.

En la mayoría de casos, el cliente ya ha trabajado duro para producir información valiosa y contenido interesante. Sin embargo, ha olvidado el punto más importante que surge de responder algunas preguntas simples:

- ¿Para quién estoy escribiendo esto?

- ¿Cómo buscaría lo que estoy escribiendo si fuera un usuario de Google?

- ¿Comprenderá Google que estoy respondiendo una pregunta específica del usuario?

Este cliente produce contenido, generalmente no para fines de SEO y tiende a escribir a través de la pasión y se siente satisfecho al hacer clic en el "botón de publicación" en su CMS después de haber puesto todo su corazón y su cerebro en el tema. Después de unos días, se da cuenta de que no han tenido ninguna visita.

Este tipo de clientes son mis preferidos. Son personas o empresas apasionadas que se involucran pero que carecen de un "coach" para que no desperdician su enorme potencial. Cuando encontramos un cliente trabajando en su sitio web y tenemos un buen potencial para comenzar, los resultados están 100% garantizados.

Cómo analizar el potencial de una web

Durante años, me tocó hacer el trabajo de encontrar manualmente las keywords, buscando que el sitio web se colocara en la segunda o tercera página de las SERPs de Google.

Puedo asegurar que fue arduo y no dió mucho fruto. ¿Por qué?

- A partir de las mejores keywords, tuve que identificar las URL en las que trabajar para obtener tráfico.

- Tuve que decidir si valía la pena cambiar la página o no. Era probable que la URL elegida ya tuviera tráfico con otras keywords, y era posible que la modificación del contenido supusiera el riesgo de perderlo.

- Antes de modificar el contenido, fue necesario analizar el SERP de Google para comprender si el texto de la página en nuestra web estaba enfocado con el otro contenido que Google eligió para el SERP. Esto me permitió saber si necesitábamos volver a reescribir la página por completo o si simplemente valía con hacer algunas mejoras.

- También necesitábamos probar qué otras keywords relevantes se podrían colocar en el mismo contenido, así que tuve que analizar las páginas de los competidores para identificar sus keywords relevantes.

- Como todos sabemos, Google no siempre responde con el mejor resultado; a menudo tiene que reaccionar con el "menos malo". Esta fue una información vital para mí, y saber que tendría menos competencia fue una gran ventaja competitiva.

Como te puedes imaginar, según la complejidad y la cantidad de información que necesitaba para evaluar cada URL, tenía dos opciones:

- Dejar este trabajo.

- Crear una herramienta automatizada que pueda hacerlo todo por sí misma.

Este dilema me dió la idea de crear SEOZoom, un conjunto de herramientas de SEO con un enfoque distinto al de cualquier otro conjunto. Quería un mecanismo "basado en la oportunidad" que me ayudara a ser ágil y reactivo.

Esto un resumen del enfoque que elegí, pero recuerda que este artículo no se trata de SEOZoom, sino de la filosofía que me llevó a crearlo y automatizar todo el trabajo.

¿Qué quieren los usuarios?

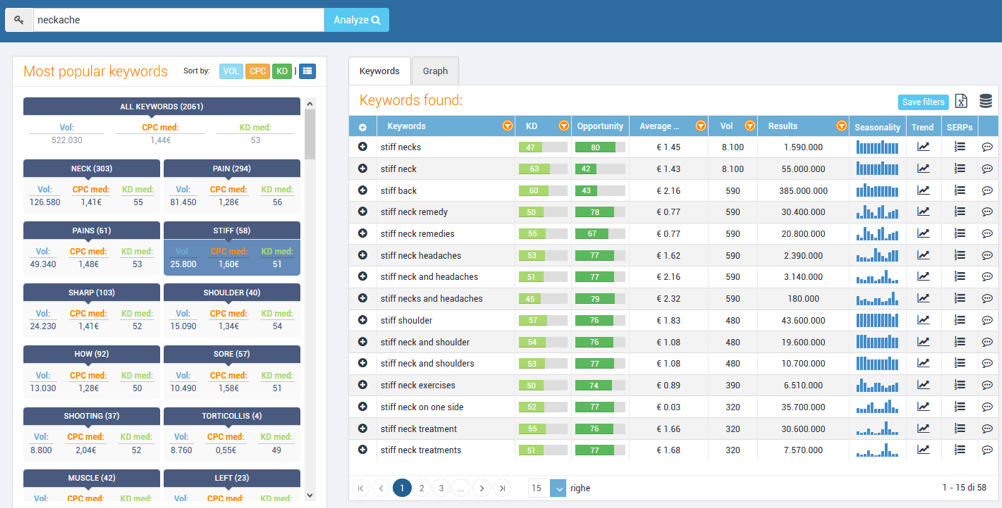

Necesitaba una herramienta que me ayudara a comprender las diferentes formas en que un usuario podría buscar lo mismo en Google, por lo que creé un algoritmo para identificar la intención de búsqueda.

Este realizó una ingeniería inversa de los SERP de Google y logró identificar todas las keywords que podrían considerarse relevantes para un tema específico.

Con el primer paso de estudiar el potencial realizado, pude entender si ciertas páginas web eran relevantes para un tema.

El clásico enfoque de posición / keywords de Track Trackers fue inadecuado y de poca ayuda.

Analizar dominios completos solo en cuadrículas (en estilo Excel) con keywords, volumen de búsqueda, posición y URL fue imposible, y habría supuesto meses para cada web.

Me pregunté cómo era posible que ninguna herramienta existente funcionara de esta manera; no podía entender cómo se clasificaba cada página en todas sus keywords en términos de tráfico orgánico.

Entonces, se me ocurrió una nueva idea para crear el primer rastreador de rangos basado en URL y no en keywords. Era algo que no existía en el mercado de SEO Suite. Por último, podría saber automáticamente para una página qué keywords generaban tráfico y otras posibles con las que podría trabajar. Y no solo eso, también podría determinar el rendimiento de la página con el tiempo.

El enfoque de "página" de SEOZoom también sirvió de inspiración para otras herramientas internacionales porque apenas un año después de nuestro lanzamiento, ya habían adaptado sus herramientas para ofrecer una solución similar, dado que podría proporcionar una visión diferente del rendimiento de cada página web.

¿Qué quieren los SEO? ¡La imagen completa!

Siempre he sido muy crítico con mi trabajo y aunque pudiera estar satisfecho con el seguimiento de una página, me di cuenta de que la herramienta era mucho más útil para un redactor que para un perfil SEO como yo.

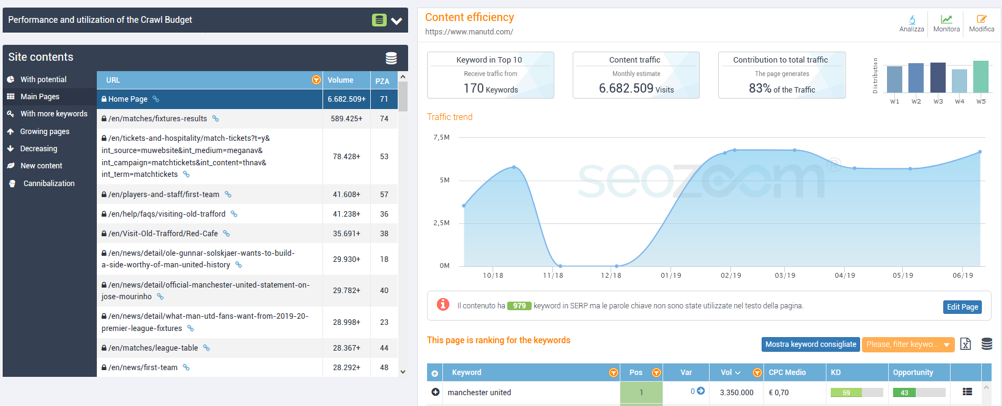

Para un redactor publicitario es conveniente saber en qué página realizar mejoras; pero, como SEO, necesitaba información suficiente para llevar a cabo acciones globales en secciones completas del sitio web. Lo que necesitaba era una "mejor visión general".

Lo que necesitaba era dividir las URL de mi sitio web y organizarlas según el volumen de tráfico y crear algoritmos de análisis de contenido para:

1. Encontrar cuántas y cuáles son las páginas que desperdician el budget crawl al llevar tráfico cero a la página.

En muchos casos, descubrí que el 90% del budget crawl se desperdiciaba en páginas que no contribuían al tráfico. Las diversas arañas SEO nos muestran los problemas técnicos de nuestras páginas, pero ninguna araña me dijo qué páginas eran útiles y cuáles eran una completa pérdida.

2. Comprender cómo de estables eran las clasificaciones de mi sitio web.

En muchos casos, solo tenemos un puñado de páginas que generan todo el tráfico y miles y miles de otras páginas que son un mero desperdicio de budget crawl. Nuestro tráfico está peligro en estas circunstancias porque si las clasificaciones de una de estas páginas web se estancan podríamos perderlo todo. Debemos actuar de inmediato para estabilizar nuestra presencia de SERP mediante el fortalecimiento del contenido.

Como podemos ver en el gráfico anterior, el 0.06% de las páginas del sitio web producen el 90.52% del tráfico. Podemos decir en casos como este que nuestro tráfico global está en riesgo.

3. Determinar si los grupos de páginas compiten por las mismas keywords identificando posibles canibalizaciones.

Cuando uno ha trabajado en una web durante años, a menudo es probable que se encuentre trabajando sobre un mismo tema en diferentes momentos. A menos que se haya administrado meticulosamente la producción de su contenido y se haya intentado no superponer su contenido antiguo y nuevo, existirá el riesgo de tener problemas de canibalización o de tener varias páginas web compitiendo por las mismas keywords. En estos casos, una de las dos páginas superará a la otra, convirtiéndose en una carga para Google porque se ve obligada a escanearla.

¡Manos a la obra!

Gracias a la herramienta que había creado, pude tener una visión general de las páginas del sitio en un instante, pero aún necesitaba una pieza final para crear la solución perfecta.

Necesitaba saber exactamente cómo mejorar cada web problemática para hacerla más competitiva y llenar los vacíos de contenido, así que creé nuevos algoritmos para automatizar el trabajo que habría hecho manualmente hasta entonces.

Este es el proceso por el que pasé para averiguar qué necesitaba hacer en cada página web:

1. Analicé el contenido de mi web para una evaluación cualitativa y cuantitativa comparándolo con el contenido de los competidores en el SERP.

2. Tenía que entender por qué mi URL estaba clasificada en la segunda página de Google para muchas keywords o no estaba clasificada para otras, mientras que las páginas de los competidores sí.

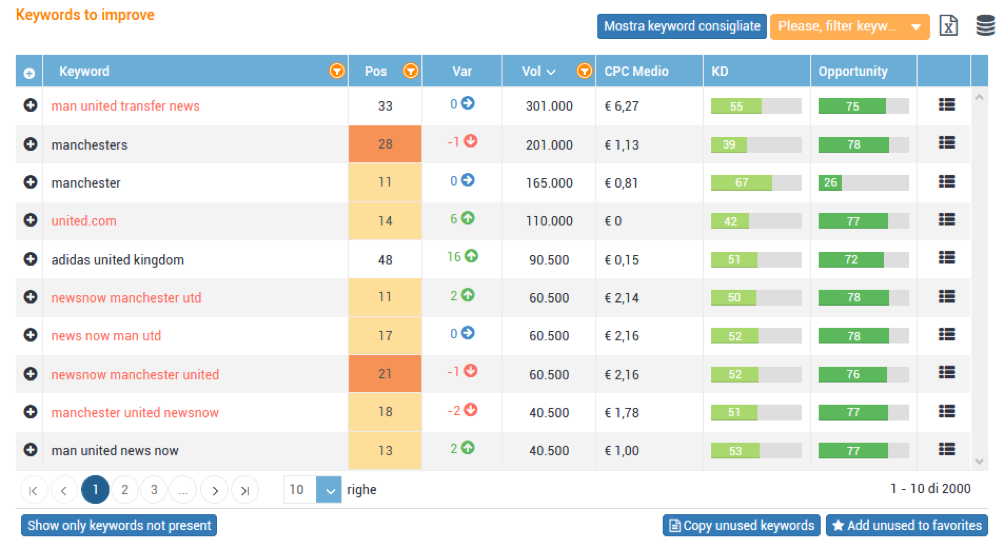

Para mitigar este problema, decidí crear un algoritmo para identificar lo que denominé la brecha de intención para identificar keywords potenciales y altamente relevantes para una URL mediante la ingeniería inversa de los resultados de Google de mis competidores.

3. Tenía que entender lo que mis competidores habían hecho en sus páginas. Necesitaba reunir información sobre su tráfico orgánico, keywords, qué temas habían cubierto en su página… pero sobre todo, qué habían hecho mejor que yo.

El procesamiento del contenido de los competidores y las keywords que clasificaron me permitió averiguar qué faltaba en mis páginas a nivel de keywords y de contenido.

En rojo, todas las keywords para las que mi página web estaba casi en Top10 pero que nunca se habían utilizado en el texto.

En rojo, todas las keywords para las que mi página web estaba casi en Top10 pero que nunca se habían utilizado en el texto.

La importancia de tener un Asistente Editorial excelente

Mi último deseo fue pasar por todo el proceso que he descrito hasta ahora, hacer clic en un botón y abrir un editor HTML que me ayudara a hacer todo lo que había identificado guiándome paso a paso y mostrándome la información de las páginas con las que iba a competir.

Quería encontrar la siguiente información sobre mis competidores:

- Qué temas habían cubierto.

- Qué keywords clasificaban.

- Cómo utilizaban las etiquetas TITLE.

- Lo que habían usado en sus H1, H2, H3.

- Qué enlaces internos utilizaban.

- Inspirarme viendo las frases utilizadas para cada tema.

- Obtener una idea inmediata del volumen de búsqueda potencial por el que estaba compitiendo con mi artículo. También quería que este posible volumen se actualizara en tiempo real mientras modificaba el texto y lo enriquecía con temas y keywords.

Me puse a trabajar y, con la ayuda de mi equipo, creé el primer asistente editorial hace tres años. Surgió por necesidad personal y, hoy en día, 22.000 empresas en Italia lo están utilizando. Otras herramientas han comenzado a ofrecer productos similares desde entonces.

Un caso en el que apliqué esta metodología

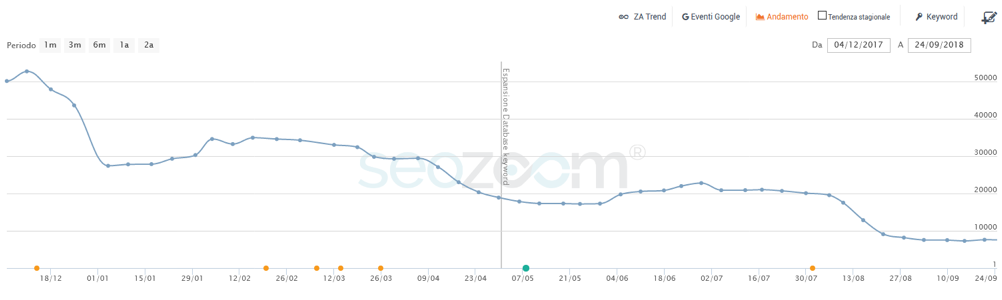

La web almeglio.it seguía perdiendo tráfico a pesar de la producción constante de nuevo contenido. Tal vez era porque había un problema en la forma en que elegían los nuevos artículos, porque las páginas antiguas estaban perdiendo tráfico gradualmente o tal vez era una combinación de ambas.

La propia web estaba provocando un desperdicio de casi el 90% del budget crawl para producir un tráfico orgánico cero. La solución fue crear en contenido más interesante para aumentar el tráfico en las páginas web que ya teníamos disponibles.

Logramos ganar todo el tráfico perdido a lo largo del tiempo al trabajar de forma selectiva en las páginas con un potencial SEO más significativo, modificando el texto para garantizar que fuera más relevante por temas.

Como puedes ver en la imagen de arriba, después de intervenir el contenido el tráfico orgánico volvió a los niveles anteriores.

Hicimos esto en aproximadamente 50 páginas dedicando aproximadamente una semana, pero el resultado fue satisfactorio.

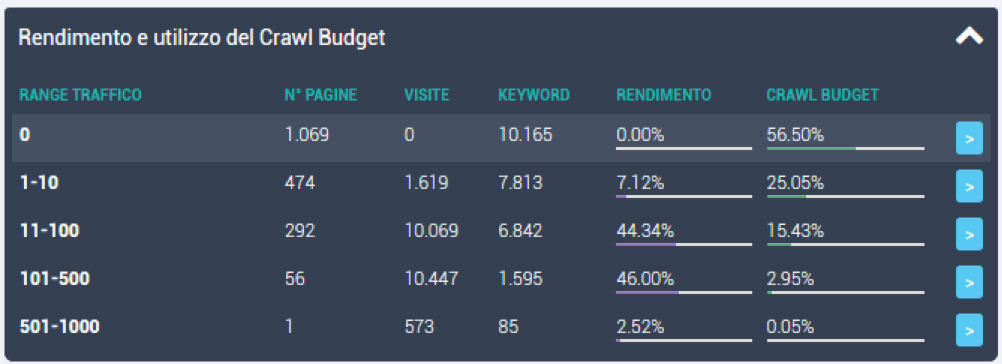

Las pocas páginas modificadas ocupaban aproximadamente el 3% del budget crawl pero, después de la intervención, producían aproximadamente el 46% del tráfico global del sitio, como se puede ver en la segunda línea de la imagen a continuación.

Finalmente, el tráfico global del sitio regresó a volúmenes de tráfico adecuados para el tipo de web y la cantidad de contenido producido.

El SEO moderno es muchas cosas, muchas disciplinas… pero como siempre digo, ¡es más una visión global!

Y es que, al igual que Neo en Matrix, solo puedes derrotar al enemigo cuando tus ojos pueden ver tu sitio web claramente en su totalidad, en su esencia.